|

[论文笔记] Learning Phrase Representations using RNN Encoder–Decoder for Statistical Machine Translation我们知道,Seq2Seq 现在已经成为了机器翻译、对话聊天、文本摘要等工作的重要模型,真正提出 Seq2Seq 的文章是《Sequence to Sequence Learning with Neural Networks》,但本篇《Learning Phrase Representations using RNN Encoder–Decoder for Statistical Machine Translation》比前者更早使用了 Seq2Seq 模型来解决机器翻译的问题,本文是该篇论文的概述。 发布信息2014 年 6 月发布于 Arxiv 上,一作是 Kyunghyun Cho,当时来自蒙特利尔大学,现在在纽约大学任教。 摘要这篇论文中提出了一种新的模型,叫做 RNN Encoder-Decoder, 并将它用来进行机器翻译和比较不同语言的短语/词组之间的语义近似程度。这个模型由两个 RNN 组成,其中 Encoder 用来将输入的序列表示成一个固定长度的向量,Decoder 则使用这个向量重建出目标序列,另外该论文提出了 GRU 的基本结构,为后来的研究奠定了基础。 因此本文的主要贡献是:

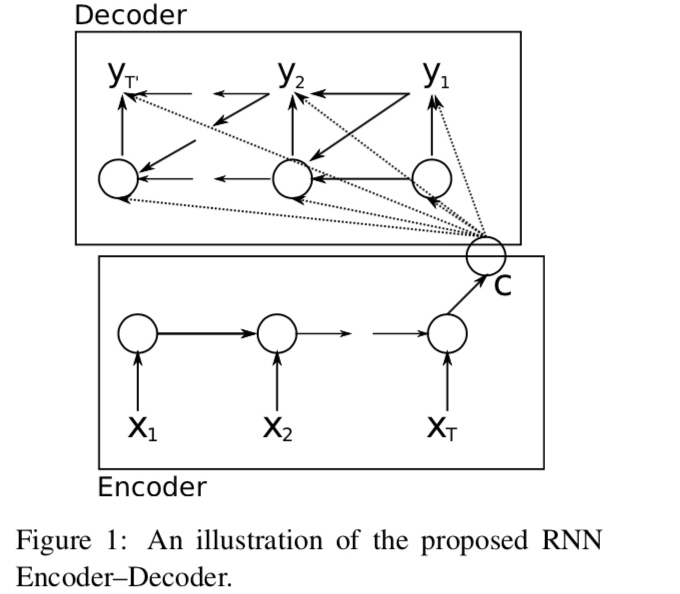

模型本文提出的模型结构如下图所示:

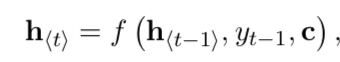

这里首先对输入上文 x 走一遍 RNN,然后得到一个固定长度的向量 c,作为 Encoder,然后接下来再根据 c 和后续隐状态和输入状态来得到后续状态,Encoder 的行为比较简单,重点在 Decoder 上。 Decoder 中 t 时刻的内部状态的 ht 为:

该时刻的输出概率则为:

模型训练时则去最大化给定输入序列 x 时输出序列为 y 的条件概率:

以上便是核心的公式,上面的这个就是该模型的优化目标。 |